- Startseite

- Neuigkeiten

- ADAS & Objekterkennung über Kamerasysteme: die rasante Entwicklung

ADAS & Objekterkennung über Kamerasysteme: die rasante Entwicklung

Etwa zeitgleich mit der Einführung des ersten Tesla Model S tauchte ein weiterer neuer Name in der Automobilbranche auf: Mobileye. Während der Fokus vieler anderer Entwickler von Sensoren zur Objekterkennung hauptsächlich auf großen Mengen und enormen Mengen vorinstallierter Daten (3D-Karten der Umgebung) lag, konzentrierte sich Mobileye hauptsächlich auf ein Kamerasystem (das mobile Auge), das reale Daten verarbeiten kann. Zeitsituationen völlig von selbst. Abschätzen können. In diesem Artikel besprechen wir, welche verschiedenen Varianten des autonomen Fahrens dies ermöglichen und wie diese Entwicklung weitergehen wird.

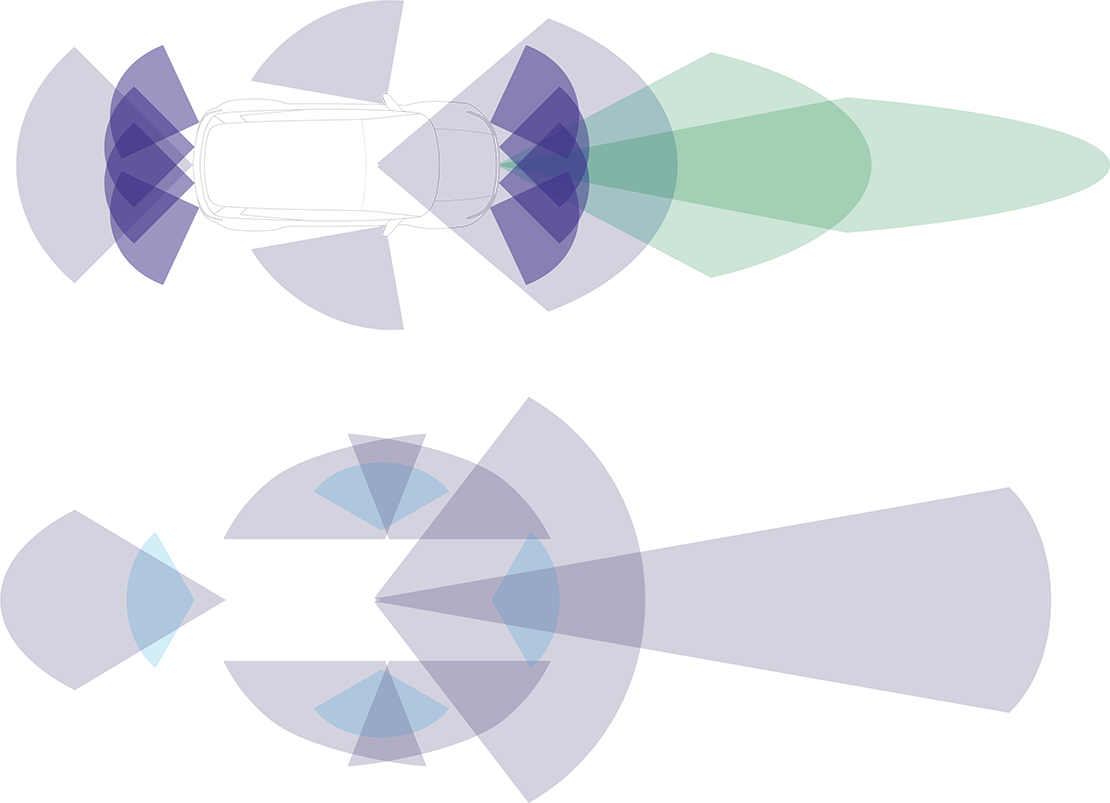

Bild: Schematische Darstellung des ADAS-Betriebs traditionell (oben) vs. ADAS-Betrieb nach Mobileye (unten)

Mobileye EyeQ: Autonomiestufe 2+

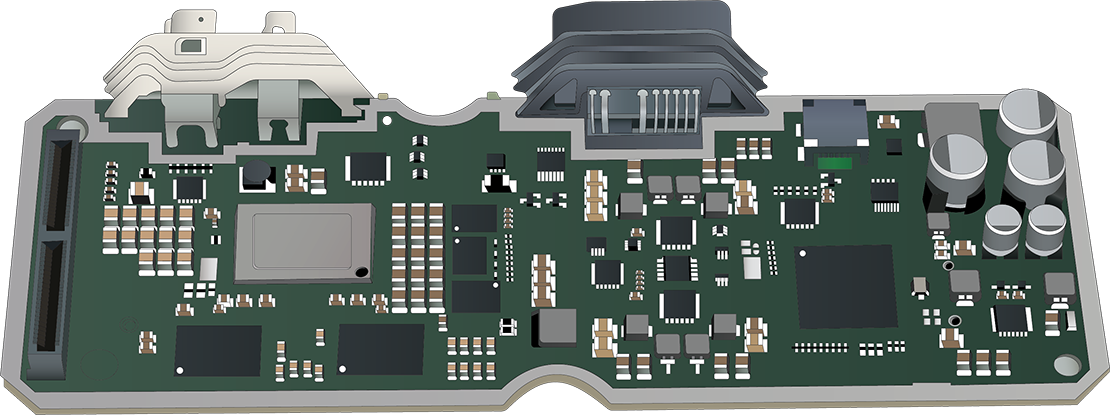

Die Basis der reinen Kameratechnologie von Mobileye ist der EyeQ: ein speziell entwickeltes SoC (System on Chip). Unmittelbar nach seiner Einführung im Jahr 2007 erregte EyeQ die Aufmerksamkeit mehrerer großer Automobilhersteller, die nach einem Partner suchten, der ein komplettes ADAS-System liefern konnte. Mittlerweile wurden weltweit über 100 Millionen (!) EyeQs verkauft, verteilt auf mehr als 700 Automodelle von mehr als 35 verschiedenen Autoherstellern. Das neueste Topmodell im Jahr 2023, der EyeQ6H, verfügt intern über einen eigenen Bildsignalprozessor (ISP), einen Grafikprozessor (GPU) und einen Video-Encoder. Dadurch ist es möglich, Systeme mit Autonomielevel 2+ zu steuern. Selbst die hochwertigsten Formen von ADAS sind für diesen SoC kein Problem. Bei Hardware dieses Kalibers ist es wahrscheinlich keine Überraschung, dass diese Technik über eine Menge Funktionalität verfügt. Funktionen wie Spurverlassenswarnung, Spurhalteassistent, automatische Notbremsung, Frontkollisionswarnung, adaptiver Tempomat, Verkehrszeichenerkennung, Fernlichtassistent und Parkassistent sind mit dem EyeQ SoC möglich. In bestimmten Fällen erhält die Zentralkamera weiterhin Radarunterstützung.

Bild: Ein Blick ins Innere des EyeQ

Mobileye REM: Autonomiestufe 3

Um die Autonomiestufe 3 oder höher zu erreichen, ohne viele Sensoren oder großformatige 3D-Karten zu verwenden, suchte Mobileye nach einer alternativen Methode der Vorerkennung, die es EyeQ ermöglichen würde, über mehr Informationen zu verfügen, als die Kamera zu diesem Zeitpunkt im Blick hatte.

Die Lösung kam 2018 in Form des Road Experience Management (REM). Im Grunde handelt es sich dabei um ein System, bei dem jedes Auto mit einem solchen neuen EyeQ-SoC kontinuierlich Informationen über die Welt speichert, die die Kamera sieht. Alle diese Informationen werden zentral gesammelt und in ein Roadbook umgewandelt: eine persönliche Echtzeitkarte, die nicht nur die Umgebung zeigt, sondern auch zeigt, wie und mit welcher Positionierung der Straßenabschnitt genutzt wird. Alle diese Informationen werden dann Over-The-Air (OTA) mit den anderen EyeQ-Fahrzeugen geteilt, die dann im autonomen Modus bessere Entscheidungen treffen können.

Sie können sich vorstellen, dass dies angesichts der großen Anzahl der im Umlauf befindlichen EyeQ-SoCs schnell zu einem vollständigen und praktischen Ganzen führt. Zumal dieses System in gewissem Umfang auch das lokale Fahrverhalten abschätzen und das autonome Fahrverhalten entsprechend anpassen kann. Beispielsweise ist es viel wichtiger, mitten in einer geschäftigen Stadt schnell zusammenzukommen, als irgendwo auf dem Land.

Mobileye Super Vision ADAS

Je mehr ADAS sich umsehen kann, desto besser funktioniert ein solches System und desto mehr Funktionalitäten sind möglich. Daher wurde SuperVision in Zusammenarbeit mit dem Automobilhersteller Geely eingeführt: eine sehr umfangreiche Form von ADAS mit nicht weniger als 7 Umgebungskameras, 4 Parkkameras und 2 SoCs.

Dieses massive Upgrade ermöglicht es dem SuperVision ADAS, viel besser zu reagieren, als es ein physischer Fahrer tun würde. Wenn beispielsweise jemand mit geöffneter Tür am Straßenrand parkt, hält das System etwas mehr (seitlichen) Abstand. Und wenn ein Fußgänger in die Nähe des Straßenabschnitts geht, verringert das Fahrzeug seine Geschwindigkeit. Auch Verkehrssituationen wie zusammenfahrende und plötzlich wechselnde Objekte kann das System deutlich besser antizipieren. Alles in allem eine schöne Entwicklung.

Radar und LiDAR als Backup

Damit Fahrzeuge vollständig autonom fahren können (Level 5), muss ein enormes Maß an Sicherheit in die Systeme eingebaut werden. Und wer wie Mobileye nur auf Kameras setzt, gerät schnell in Schwierigkeiten. Nicht, weil autonomes Fahren alleine mit Kameras nicht möglich wäre, sondern einfach, weil es kein Backup gibt, das prüft, ob die Kameras die richtigen Informationen sehen und das System die richtige Bewertung vornimmt. Aus diesem Grund wurde die Entscheidung getroffen, sowohl Radar als auch LiDAR zu verwenden. Allerdings ist die Vorgehensweise ganz anders, wie auch die folgende Tabelle zeigt. Mobileye sieht Radar und LiDAR nicht als Ergänzung zur Vervollständigung der Informationen, sondern vertraut seinem eigenen Kamerasystem genug, um Radar und LiDAR als reine Kontrollmittel zu betrachten. Sie nennen dies „echte Redundanz“.

Auch Nvidia arbeitet am autonomen Fahren

Während Mobileye vor allem auf ein universell einsetzbares System setzt, das sich relativ einfach überall implementieren lässt, sieht der Tech-Riese Nvidia die Probleme rund um das autonome Fahren und die damit verbundenen gigantischen Datenmengen schon immer anders. Da Nvidia seine Wurzeln in der (Grafik-)Computerindustrie hat, betrachten sie die Objekterkennung nicht als separates System, sondern als Teil des Gesamtbildes: des gesamten Autos. Eigentlich ist es ein bisschen so, als ob eine Grafikkarte Teil eines kompletten PCs ist.

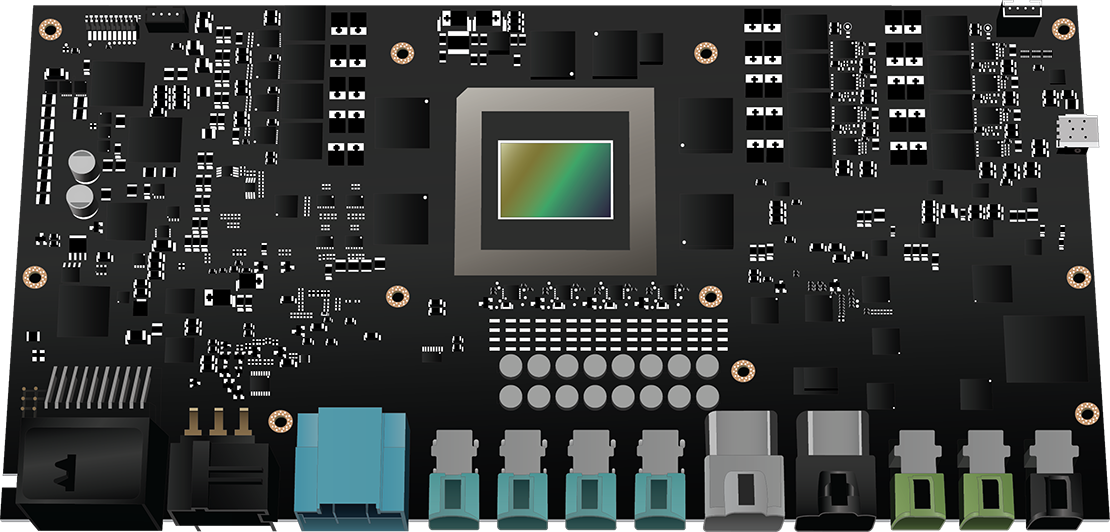

Bild: Der Nvidia DRIVE Thor im Detail

Im September 2022 kündigte Nvidia daher den „DRIVE Thor“ an, einen allumfassenden Zentralrechner, der auch Systeme wie autonomes Fahren und Parken, Insassenüberwachung, Infotainment und das digitale Instrumentenpanel steuert. Vor allem die enorme Rechenleistung (2000 Teraflops) ist Thors Stärke und macht mehrere separate Steuergeräte völlig überflüssig. Die Plattform ermöglicht zudem Multi-Domain-Computing, mit dem beispielsweise das autonome Fahren völlig unabhängig und damit sicher zusätzlich zu den anderen Funktionen innerhalb dieses Supercomputers funktionieren kann.

Wie sich die Objekterkennung auf das Motormanagement auswirkt

Ihnen ist wahrscheinlich klar geworden, dass all diese Systeme einen großen Einfluss auf die Auswahl des Steuergeräts haben können. Die Botschaft, die wir mit diesen Informationen vermitteln wollen, ist, dass die Diagnose mit dieser neuen Technologie nie wieder die gleiche sein wird: Das Gaspedal ist nicht mehr der einzige Input, auf den das Motormanagement reagieren muss. Die Suche nach der Ursache einer Fehlfunktion wird daher zu einer komplexen Angelegenheit: Ist das Steuergerät wirklich defekt, was eine Reparatur des Steuegerätes erforderlich machen würde? Oder erhält es einfach nicht die richtige Eingabe? Und liegt die Ursache woanders im Auto?

da

da en

en es

es fr

fr it

it nb

nb nl

nl pt

pt sv

sv fi

fi